现在是2024年6月29日,自ChatGPT发布(2022年11月30日)已经过了1年半,时间过得好快,而且AI发展进化得好快。

这一年半,我粗略统计了我的消费,直接花在AI上大约4000块。组成结构大概包含:包月的AI服务2-3个,20刀一个月,大模型API 1000人民币不到,用于日常工具和开发研究。包月的AI服务比如Github Copilot、Poe、ChatGPT Plus,还有最近的Kagi,API包含OpenAI中转商、国内的零一、Deepseek。这几千块钱也许是我花的最值的自我投资,通过这些AI工具让我的个人效率10倍的提升,可以说飞升成为100x程序员了【1】。

在使用AI并且研究AI的这段时间里,我也有了一些感悟,想记录分享一下,写的比较乱,想到啥写啥了。

会用AI的人,与不会用AI或者不用AI的人拉开更大的差距

这个观点算是老生常谈了,例如之前redis的作者antirez也提到过。从过去的关键字搜索转变到自然语言构建Prompt,甚至是用英语构建Prompt,这个转变很多人无法适应。但从ChatGPT发布开始,规则就在一瞬间转变了。

过去擅长从问题中提取关键字的人,现在要开始善于将问题描述的越来越详细。相信这难不倒过去善于使用传统搜索引擎的人,但没有理解现在AI运作原理的人或者思维没有转变的人,使用AI通常无法获得理想的效果,举个例子,我见到有人这样询问AI:”Java 洗牌”,说不好他是懒还是不明白如何使用AI,在传统的搜索引擎时代也许搜索引擎会根据这个关键字给你匹配一系列的结果,然后你去挑一篇文章看。但AI时代如果这么去问问题有一定的概率AI会对你胡言乱语,并且大概率给你的东西你没法直接用,如果要得到更好的结果,在描述的过程中可能需要给出更多的上下文和要求:”请用Java编写一段用于洗牌的算法,要求不修改原来的数组返回一个新数组“。这样AI就能直接生成一段你直接能够复制粘贴的代码,然后再要求AI:”为这段代码生成3个corner case的JUnit5测试用例。“来进行单元测试。

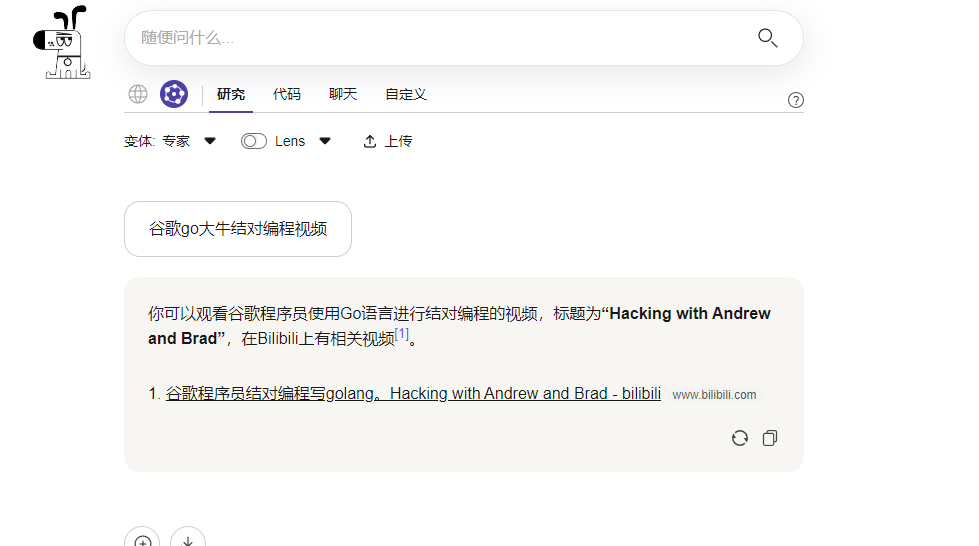

搜索是最接地气的AI使用场景,我已经为AI搜索开始付费了,它为我带来了什么提升呢?举一个我现实碰到的情况,在群里吹水时突然提到了几年前我看的一个编程视频,但是我没有保存链接,这个时候我用AI搜索:

如果我使用的是传统的搜索,那么搜索的情况是如下:

根本无法找到我想要的那个视频,但是AI搜索却能够理解我的意思并且精准的找到了对应的视频(虽然也是依赖于Kagi高质量的搜索结果)。

我无法估计通过AI搜索为我节省了多少时间,也无法估计我写的AI小工具能够提高我多少效率,更无法统计如果没有AI的帮助我会少学习到多少知识,但剥夺了AI我的工作和学习会非常不习惯,就像突然回到现金支付的社会一样。

AI还是要依赖基础设施

在刚刚聊搜索的时候,聊到了Kagi的AI搜索厉害最重要的还是基于Kagi自己搜索的高质量结果集,这很能体现AI产品的特点,那就是基础设施决定了AI的能力下限。

Perplexity说要替代Google成为新时代的搜索引擎,但其实它底层使用的还是Google提供的搜索API,只要Google不让它使用API了,它只能切换到Bing或者别的搜索引擎,那么它的能力大概率会降低。所以它说要取代Google基本上是不可能的,Google要赶上它的AI总结能力很简单,但是它要超过Google的搜索能力难度就堪比登天了。

不需要基础设施的应用应该就只有聊天系和生成系,这完全是靠大模型自己的能力,但是单纯这两种场景的应用场景太有限了,要能作为产生价值的工具,基本是依靠大量的基础设施来完成的。

比如PPT生成,AI目前的能力只能为PPT生成大纲、PPT中的文字、PPT中的图片,像是PPT的排版、格式调整、动画效果都需要用模板来实现,最多让AI进行选择哪个模板更适合演讲主题;再比如网站生成,AI并没有能力为你生成一整个网站,它最多为你生成一个”网页“而且并不完美,AI网站生成大部分的能力都来自非AI时代时这些网站生成网站积累的模板再加上AI的文字和图片生成的能力。

现在很火的Agent,也需要实现非常多的基础设施能力。这些能力提供给AI后,AI可以帮我们实现自动化操作这一步,所以我认为不管是想要创业还是想要用AI进行赋能的人,先搞好基础设施,再把AI加到基础设施里。

不一定必须用到最强的智能

是否产品一定要使用当前最聪明的人工智能?根据产品的形态其实是不需要的,经过特定任务微调的小模型在某些场景下一样可以发挥出SOTA模型的能力。

比如说情感识别或者错别字检测,都不一定要用到GPT4o或者Cluade3 Opus来完成,使用小型模型能在百分之一成本下同样高质量的完成任务。

但这些都属于降本了,在产品开发验证完PMF之后,才需要进行降本,也就是李开复老师提到过的TCPMF,technology cost product market fit,产品和市场契合,再去寻求技术成本的契合。个人理解的PMF只是产品能够向前跑的验证,能跑多远可能就要看TCPMF了,健康的盈利才是可持续发展的。

产品不追求最强的智能还有一个好处,能够利用上开源的模型进行本地部署。在许多需要数据安全的行业,不希望自己的很多隐私信息被发送到大模型厂商处,第一是绝大多数的大模型厂商都会在使用条款里说明自己有权利拿用户数据来进行大模型训练(国内厂商大多都是),更有厂商会无视用户的隐私和版权使用数据来进行模型训练(就是说的那个不敢Open的AI);第二是这些数据有时候涉及到商业机密,就算不被用于模型的计算,但在公网上通过大模型对于这些商业机密进行一系列的处理也是增加了很多的风险(并且大模型也是能够进行一些注入攻击的,如果恰好程序里有一些函数调用能力,那么有可能就会导致商业机密泄露)。而且云厂商的API费用有时候不比自己购买硬件+电费来的便宜,对于需要巨大token用量的场景,本地部署甚至能省钱。

预研要用比SOTA模型更强的假设来做

是否产品研发就按照大模型的能力边界来进行呢?大模型的发展速度太快了,做研究一定要用现在最强模型的能力或者超越它的能力来进行假设,否则研究很快就过时,因为模型的发展大大超过想象,现在已经有开源大模型的能力可以追赶上去年GPT-4 turbo的水平了,也就意味着去年用GPT4t做研发的产品,已经完全可以进行本地部署了。同样我们可以展望,未来也有4o级别的本地模型,让我们来进行多模态的开发。

所以现在的产品想象力,可能需要最少在4o的基础上来进行,甚至把这个水平拉到4o之上去想象。这个想象可以是多个维度的,比如成本,如果token不要钱了,产品可以如何设计?又比如速度,假如以后得输出都像groq一样1000t/s,产品又会出现什么变化?再比如维度,现在基本是语音、文字、图片,假如以后增加视频甚至一些更加底层的端到端如电信号到控制向量,这时候产品又如何来设计?

用Github Copilot举例,是否在token够便宜大模型上下文够长的时候,全量的代码和数据库设计是每次都包含在上下文中的,这样能够让大模型在每次对话的时候都能理解代码中全部细节,而不需要像现在这样费心费力的去选中代码或者RAG;如果速度够快了,是否可以让大模型互相讨论生成的结果10次,来获取更加完善正确的结果再进行返回;如果维度增加了,是否可以端到端的“语音输入”到“VSCode操作输出”,从而达到Copilot全权控制我的VSCode,而我说话只要告诉大模型我的需求。

同样现在被人诟病的幻觉情况也是一样,按照假如幻觉是可以控制开关的情况来设计是最好的。

利用幻觉

为什么我要说幻觉要控制开关?

我隐约记得在一本书中看过这种理念,“不要对抗自己的负面情绪,而是要利用它“,每个人都有懒惰、欲望之类的负面情绪,如何正确的去利用它而不是对抗它,会让你从痛苦变为幸福。比如我可以在我抗拒学习的时候,促使我进行运动;我可以在我想吃肉的时候,为我的工作设立一个高目标并且奖励自己一顿烤肉,从而让我更高效更有动力的去完成工作。

大模型有幻觉的特点,并且还有两个参数温度和topk用于控制回答的多样性,但就算是把温度设置为0,topk设置为最小,也不会让大模型完全没有幻觉。幻觉和回答的多样性不同,幻觉是在大模型不知道某事的时候,认为自己知道而进行的胡言乱语。

但如果把幻觉当成模型的想象力,那大模型就很有可能迸发出许多不一样的能力。

在许多需要“创造力”的领域,利用大模型的幻觉可以进行充分的想象,有时候是超越了“想象”的想象,因为大模型自己也不知道它胡言乱语的什么,比如下面的问题,如果是你你会如何回答?

在类似角色扮演、写作、头脑风暴,甚至是一些特殊的研究领域,这种不走寻常路的胡言乱语经常可以给用户一种富有创造力的错觉。

目前的AI要替代人类还早,想想无人驾驶

每当科技向前推进一步的时候,都会有替代人类、失业之类的论调,甚至总是有人为了炒作热度而把新事物的出现与工业革命相提并论。但AI这次不一样,它是真真实实影响到了人类,也可预见的会像工业革命一样会让社会产生变革,从工业社会转变为全自动化生产社会,将生产力再次提高一个数量级。

但是,是现在吗?自动驾驶L2发布多少年了,也一直有以后不需要司机的论调出现(我甚至一度收到这种言论的影响而懒得去练车),而近两年才真正的开始真的无人的士(但还是需要安全员),最近特斯拉的FSD似乎比之前的自动驾驶有很大的进展,也许马上就真的不会有司机甚至汽车都不会有驾驶位。

在某次直播中,有位程序员大佬说了“你在工作中用过AI就知道了,AI目前不可能替代人类编码,AI很难根据你的描述来生成完全符合你要求的一个复杂的程序,要做到这些,需要定义一种语言,让计算机严格按照你的指示来做,但那其实就是编程,你还是需要编程”。目前看来很有道理,AI确实暂时威胁不到程序员,因为AI能力的天花板很容易看见,他目前能做到高中的智力水平以及囊括极为广泛的知识和无限的体力,如果某些工作只需要这样就能做,那么就很有可能被AI替代。

这样的工作多吗,非常多。首当其冲的是不需要智力的工作,诸如配音、录入信息、填表、分类等等,这些只要有识字级别的知识水平加上简单的教学就能上岗;其次是需要一些简单的领域知识,但是又无需太过高级的智力去做决策的,如各种客服人员、财务律师医生等职业的助理人员等等;再往高级一些就是需要碾压用户的智商才能胜任的工作,比如中小学教师、市场分析人员、销售人员等,这些职业在某些特定的情况下,面对的用户可能有信息或者智力差。再要更高级,就已经达到了当前AI的能力边界了,目前来说大部分的程序员都无需担心,AI的能力在测试集上都无法达到100%解决问题,何况现实的业务更加复杂。

那么我举例的职业里,真的都被淘汰了吗?当然没有淘汰,使用AI去淘汰这些职业是需要理由的,AI如果能够做到比他们更好更便宜也许是会慢慢进行淘汰的,但目前AI的问题还没有解决。

在AI如此高速发展的两三年里,可以预想到未来肯定是会将这些:简单的、重复的、需要大量人力去做的工作用AI去代替的。也可以预想到再更久的将来,一定会代替更需要智力的高级工作。我们也不应该感到焦虑,马车夫失业了会有司机,司机失业了也肯定会有更高级的职业,Midjourney让部分画师失业,也让部分Prompt Engineer获得工作,保持跟进才是我们应该做的。

【1】10x程序员的概念可以参考这篇文章http://antirez.com/news/112,在这个基础上再提升10x,就成为了100x程序员。

0 条评论